Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

samsja

Провідні наукові дослідження в @PrimeIntellect

Я наймаю інженера-дослідника в @PrimeIntellect

Ми створюємо agi labs з відкритим вихідним кодом і шукаємо необроблені таланти. Нам начхати на вашу попередню посаду.

Усі в дослідницькій команді працюють на full stack, ми будуємо інфраструктуру, а також дивимося на дані. Якщо у вас є золота середина для законів про систему, навчання з підкріпленням, дані або масштабування, вам буде запропоновано безліч завдань для вирішення

30,2K

Декларативна система текстової бази переможе, пора заново винаходити комп'ютер

samsja17 серп., 08:09

Можливо, llm + nixos врятують linux, зробивши свого користувача в 10 разів потужнішим, маючи комп'ютерний agi, підключений до ОС. Уявіть, що ви просто питаєте: «Чи можу я встановити курсор і перенести на нього всі мої налаштування vscode»

Тим часом користувач macOS все ще використовуватиме мишу, щоб завантажити та налаштувати все вручну

Таке короткострокове бачення, щоб хотіти навчити модель бачення робити клік для мене, потрібно все переробити для агі

1,87K

Можливо, llm + nixos врятують linux, зробивши свого користувача в 10 разів потужнішим, маючи комп'ютерний agi, підключений до ОС. Уявіть, що ви просто питаєте: «Чи можу я встановити курсор і перенести на нього всі мої налаштування vscode»

Тим часом користувач macOS все ще використовуватиме мишу, щоб завантажити та налаштувати все вручну

Таке короткострокове бачення, щоб хотіти навчити модель бачення робити клік для мене, потрібно все переробити для агі

samsja17 серп., 07:46

Хіба Nixos не є кінцевою грою Sandbox для LLM?

10,23K

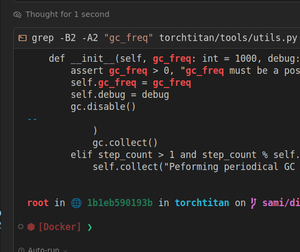

RL настільки чутливий до чисел, що минулого разу, коли компіляція torch робила якийсь збій, тепер vllm v1

Mika Senghaas12 серп., 11:23

Перехід з VLLM V0 на V1 призвів до збою нашого тренування Async RL! Читайте, як ми це виправили

Нещодавно ми перейшли з V0 на V1 в рамках більшого рефакторингу Prime-RL, щоб зробити його простішим у використанні, більш продуктивним і, природно, асинхронним. Ми підтвердили правильну динаміку тренувань на багатьох пробіжках меншого масштабу, але вдарилися об стіну, намагаючись відтворити біг більшого масштабу, який пробігав без проблем до рефакторингу. Зокрема, тренування DeepSeek-R1-Distill-Qwen-1.5B на однооборотних математичних задачах з нашого математичного набору INTELLECT-2 в контексті 8k з двоетапною затримкою відхилення від політики фатально зазнає фатального збою приблизно через 400 кроків тренування

6,63K

o1/o3 були справжнім GPT5, і вони забезпечили важкий, можливо, більший стрибок, ніж GPT3 до 4, RL все ще продовжує дотримуватися закону масштабування

Попереднє навчання також масштабується, але висновок занадто дорогий з гігантською моделлю

Погодьтеся, що відкритий вихідний код виграє

Yuchen Jin10 серп., 12:04

GPT-5 двічі виходив з ладу.

Законам про масштабування приходить кінець.

Штучний інтелект з відкритим вихідним кодом матиме Мандат Небес.

4,22K

Найкращі

Рейтинг

Вибране

Актуальне ончейн

Популярні в X

Нещодавнє найкраще фінансування

Найбільш варте уваги