Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

ludwig

Guds utvalgte hovedingeniør. Det som er umulig for deg er ikke umulig for meg.

Jeg kjenner ingen som er i feltet og er en seriøs person som fullstendig tilbakeviste Lecuns ideer tbf, problemet var alltid at han er sin egen verste talsperson og stinker av fr*nch akademisk hovmod

kache15. aug., 01:05

Yann le cunn vil bli rettferdiggjort btw

40,04K

Jeg beklager at jeg har vært slem til tider i det siste, jeg kommer til å gå tilbake til #LiveLoveLaugh #JustAKidFromAkron modus

Det er mange fantastiske mennesker her og en uendelig tilførsel av interessante ting å snakke og tenke på, og å fokusere for mye på de negative tingene i kulturen eller bransjen osv kan få deg til å glemme det

10,45K

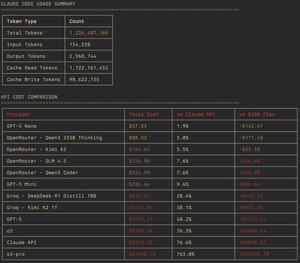

litt serviettmatematikk om hvorfor Claude Code med 200USD-planen i utgangspunktet er uslåelig hvis du har >1B tokens i måneden og vil ha den "best mulige modellen uten å gå blakk"

Hver modell billigere enn den er verre, hver modell dyrere enn den er sjelden objektivt sett bedre

Tl; dr den eneste måten for GPT-5 å erstatte Claude Code i en tung arbeidsflyt er enten: du bruker falske VC / selskapspenger eller kostnadene subsidieres gjennom noe sånt som Cursor eller et tilsvarende OpenAI-abonnement som bunter codex cli-bruk

31,03K

noen tilfeldige TT-Evolve-skjermbilder fra 1. august (sist gang jeg jobbet med det 🙏)

Noen vær så snill å mobbe meg til å gi ut dette for Tenstorrent-folkens... det er ikke mye, det er i utgangspunktet en sele som lar deg slippe en TT-metallkjerne, legge til noen "EVOLVE"-blokker, fange tonnevis av profileringsinformasjon og kjøre et LLM-basert søk parallelt med profileringsberegningene som veiledning for å finne optimaliseringer (binning av kjernekandidater med MAP-Elites), i utgangspunktet en re-implementering av AlphaEvolve.

Det har blitt gjort i flere måneder, jeg ble bare distrahert + jeg kan sjelden slå på Big Dave på grunn av lyden og at den er på kontoret mitt (og kontoret mitt er okkupert av min Stardew Valley-avhengige kjæreste om kveldene).

Jeg synes ikke den er spesielt godt laget, men den har en fin TUI, den kan fungere for tt-nn-moduler, har noen fine devx her og der, og den optimaliserer absolutt metallkjerner (inkludert multi-chip). Den fikk absolutt hver eneste programming_examples/kjerner jeg har prøvd å være raskere, optimalisert NoC-båndbredde osv...

5,89K

en interessant merknad er at hele "det er ikke bare {{{ting}}} - det er {{{større ting}}}" skrevet særhet som er assosiert med ChatGPT er sinnsykt vanlig i Sonnet/Opus 4. Sonnet spammer det hele tiden og føler seg veldig tilbøyelig til å slurve med ting, og Opus vil snike disse inn i det mest skremmende øyeblikket, og begge er utsatt for subtil sykofani i chat-modus (det er måter å trampe det ut gjennom jording med nettsøk osv... men selv da)

jeg antar at poenget mitt er at det ikke bare er et ChatGPT-problem – det er egentlig en grunnleggende konsekvens av RLHF benchmarkmaxxing western slop!

5,83K

det er noe litt trist at å forutsi fMRI-hjerneresponser på naturalistiske videostimuli, kan gjøre det utrolig bra med bare noen data og, dessverre, et par Python-linjer

Skjønner du hva jeg mener? Som at koden er lesbar og forenklet av natur (så det er tilfellet for AVG Transformers-modellen som bruker Torch, etc)

Som Torch og Python er et for godt API over Cuda-kjerner, fjerner det nesten noe av sjarmen

enkel rumpekode som kaller "ganske enkel veldig rask matematikk" + mye data er nok

den eneste komplekse delen er ML-kompilatoren og målets arkitektur

alt dette er helt selvinnlysende og velkjent, det er ikke en erkjennelse eller noe, jeg synes bare det er morsomt at å forutsi hjerneresponser er 500 loc python og litt data i 2025 (takket være Lovecraft-kompleksiteten til moderne GPUer og ML-kompilatorer som er så pent gjemt bort)

25,63K

Topp

Rangering

Favoritter

Trendende onchain

Trendende på X

Nylig toppfinansiering

Mest lagt merke til